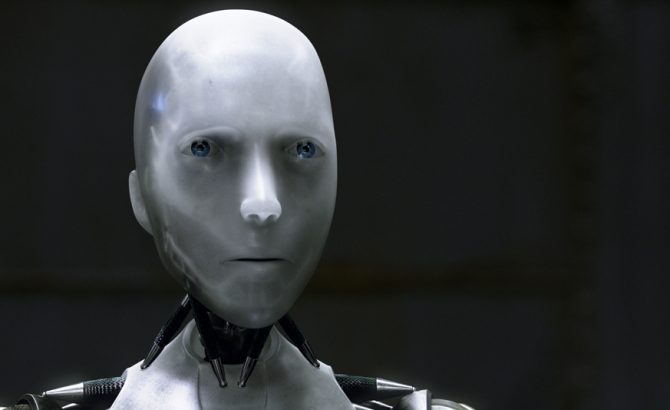

La Comisión Europea (CE) busca sus propias leyes robóticas, como ya hizo Isaac Asimov en sus libros. La CE ha reunido este jueves a 52 expertos con los que se ha creado el nuevo Grupo de Alto Nivel sobre Inteligencia Artificial que abordará los temas relacionados con la ética de las personalidades artificiales (robots e IA). De esta forma busca legislar al respecto, como tarde, para principios de 2020.

«Se busca que las personalidades artificiales tengan algo así como una religión robótica, un código ético interno que se añade al crear el software para que tenga unos mínimos éticos», explica el jurista. Incluso en el ámbito armamentístico se buscan «cinco reglas básicas» que los desarrolladores deberán añadir «sí o sí» a sus personalidades artificiales. Al más puro estilo de la ciencia ficción. «No van a ser las de Asimov en sí» pero se busca algo similar.

Tanto los robots como las inteligencias artificiales primero tienen que aprender para poder hacer su trabajo, es decir, lo que se denomina machine learning. «Por ejemplo, tienes comentarios en un sitio web y le dices estos son buenos y estos malos», explica a Hipertextual Jorge Morrell, jurista especializado en Derecho Tecnológico desde Términos y Condiciones. Y entonces aprende a catalogarlos según las pautas que tienen todos en común. “Es el ejemplo más fácil”, añade. «Pero cuando vas a cosas más complejas que afectan a personas, los datos que le das para entrenar están sesgados o son demasiado parciales en cuestiones raciales, de intereses, de pensamiento… Generas una IA que al final va a tomar decisiones tanto ética como legalmente complejas o que se salgan de la norma», explica. «El primer problema que hay para regular la IA y su vertiente ética es dónde has conseguido los datos con los que lo vas a entrenar y si el programador o la empresa se ha dado cuenta si hay algún sesgo en particular», señala.

En Estados Unidos están utilizando COMPAS, un programa que ayuda a los jueces a saber si la persona que puede quedar libre tienen probabilidades de volver a reincidir. Esta IA se basa en estadísticas de las últimas décadas y según la situación personal del individuo, tendrá más o menos posibilidades de volver a cometer un delito. “Este sistema se está teniendo bastante en cuenta en EEUU”, afirma el jurista. “Pero se han dado cuenta de que este sistema tiene un sesgo racista”, añade Morell. Es un ejemplo de por qué habría que regular a las personalidades artificiales para que no haya discriminación de ningún tipo.

Otro ejemplo es el caso de la IA agresiva de Google. DeepMind es la IA en la que trabaja la empresa norteamericana y que ha sorprendido mientras jugaba a un simple juego de recolecciónde frutas. Fue programada para recolectar el máximo de frutas posibles. Sin embargo, «en época de escasez, se volvía agresiva y los programadores tuvieron que reprogramarla para que fuera colaborativa«, explica Morell desde el otro lado del teléfono.

Estos factores éticos y muchos otros, como se pueden presentar con los accidentes de vehículos autónomos, son los que tratan de dilucidar los expertos reunidos en Bruselas este jueves, que «presentará sus directrices a comienzos de 2019«, según prevé la CE en su página web.

Parece que pronto tendremos nuestras propias leyes robóticas y, una vez más, la ciencia ficción parece haberle ganado la carrera a la realidad.

Fuente: https://hipertextual.com