Ronald Palacios Castrillo

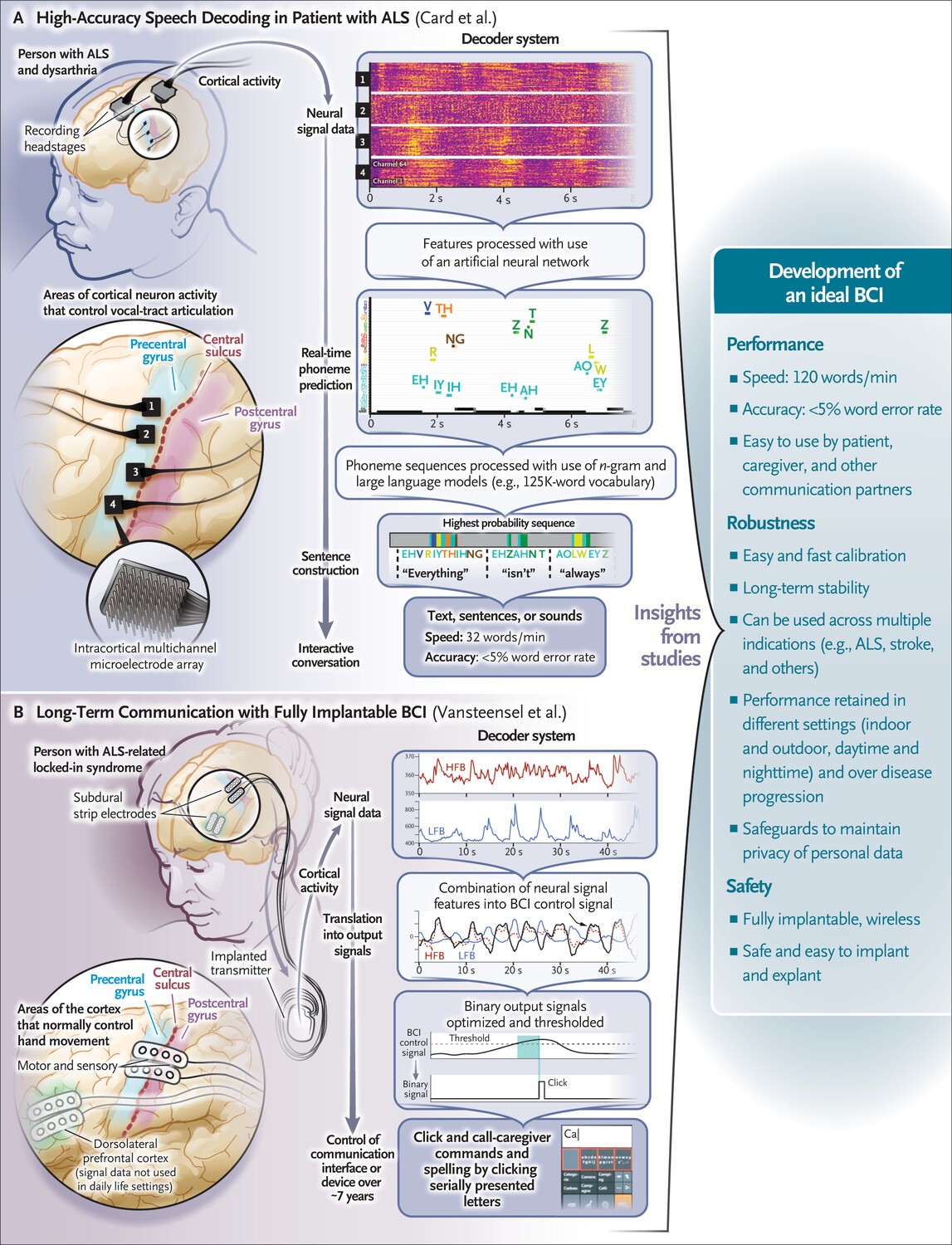

Recientemente, Card et al.[1] y Vansteensel et al.[2] describen a dos pacientes, uno con disartria grave (dificultad para hablar) y el otro con anartria (incapacidad para articular el habla). Ambos pacientes tenían esclerosis lateral amiotrófica (ELA). Cada uno recibió una interfaz cerebro-computadora de “comunicación”.

¿Qué es una interfaz cerebro-computadora?

Una interfaz cerebro-computadora es una tecnología que permite la comunicación directa entre el cerebro y dispositivos informáticos externos. Decodifica las señales cerebrales para facilitar la comunicación y la interacción con el entorno.

La estrategia básica de una interfaz cerebro-computadora consiste en registrar la actividad cortical mediante una interfaz que comprende una serie de electrodos que detectan y transmiten la actividad eléctrica del cerebro.

=> Recibir por Whatsapp las noticias destacadas

Las series de electrodos varían en un espectro de invasividad: algunas miden la actividad desde fuera del cráneo y otras se colocan en la superficie del cerebro o se insertan dentro de la corteza. Pero todas las interfaces de comunicación cerebro-computadora registran la actividad cortical de regiones cerebrales intactas implicadas en el control motor o la producción del habla.

Al decodificar la actividad cortical durante los intentos de hablar o los movimientos intentados, estas señales se pueden traducir con el uso de algoritmos computacionales avanzados en oraciones, sonidos o acciones motoras como movimientos del cursor. Un tipo específico de interfaz de comunicación cerebro-computadora, conocida como neuroprótesis del habla, restaura el habla traduciendo la actividad cortical en oraciones de texto, generando sonido de habla sintético o ambas cosas (Figura 1)[3].

Durante la última década, el concepto de neuroprótesis del habla ha pasado de ser ciencia ficción a realidad. Los primeros intentos de crear interfaces cerebro-computadora se centraron en el control motor de cursores y miembros robóticos, pero la idea de recuperar el habla parecía inalcanzable dada la complejidad del lenguaje. No obstante, la recuperación del habla es fundamental para la comunicación naturalista, por lo que la búsqueda de la recuperación del habla continuó.

El progreso en el desarrollo de neuroprótesis del habla ha sido posible recientemente gracias a los avances científicos en la comprensión de la dinámica neuronal del control motor del habla en el cerebro humano y a los avances en los métodos de inteligencia artificial que pueden aprender la compleja asignación de señales cerebrales al habla[4].

En hablantes sin discapacidad, los movimientos del habla están coordinados por una gran área del giro precentral ventral, que controla directamente los articuladores del tracto vocal, como los labios, la mandíbula, la lengua y la laringe, así como los comandos de planificación del habla de orden superior.4.

Los movimientos coordinados de estos articuladores del tracto vocal dan lugar a todas las consonantes y vocales, y este nuevo conocimiento facilitó las primeras demostraciones de descodificación del habla en hablantes sin discapacidad[5,6].

Los hallazgos de estos estudios definieron patrones clave de señalización neuronal y regiones corticales para el habla en hablantes sin discapacidad, lo que condujo directamente a ensayos clínicos de interfaces cerebro-computadora en personas con parálisis.

El primero de estos ensayos demostró una decodificación exitosa de palabras y oraciones en una persona con cuadriplejia espástica grave y anartria, a la que se le había colocado un conjunto de electrodos, con 128 sensores de electrodos, en la superficie de su corteza del habla[7].

Las señales cerebrales registradas se tradujeron en tiempo real en palabras, y las oraciones se mostraron en una pantalla de computadora.

Un estudio posterior en el que se insertaron conjuntos de microelectrodos intracorticales en la corteza precentral ventral logró la decodificación del habla en texto a una velocidad más rápida (hasta aproximadamente 60 palabras por minuto) con un amplio vocabulario de palabras[8].

Otro estudio, que aprovechó un conjunto de electrodos de superficie de alta densidad de 253 canales, logró una decodificación de texto u oraciones de alto rendimiento a 80 palabras por minuto, al tiempo que demostró la síntesis de formas de onda del habla audibles (sonidos hablados) y el control de un avatar digital[9]. (Durante las conversaciones, las velocidades típicas del habla son aproximadamente 150 palabras por minuto).

¿Y los nuevos estudios?

Los hallazgos de Card et al. representan un nuevo hito en el desempeño de las neuroprótesis del habla. Aunque la velocidad del habla era de aproximadamente 32 palabras por minuto, la precisión de las palabras era muy alta, con una tasa de error de menos del 5% en un vocabulario abierto de palabras.

Para poner esto en perspectiva, este desempeño se aproxima a la precisión de los sistemas de reconocimiento de voz modernos, que están entrenados para transcribir audio en oraciones de texto.

El decodificador podría aprender palabras poco comunes y podría entrenarse rápidamente y recalibrarse en línea, lo que no se había demostrado anteriormente. Quizás lo más importante es que Card et al. proporcionó evidencia de uso en el mundo real, en el que la neuroprótesis del habla se utilizó en conversaciones interactivas.

En línea con estudios anteriores y utilizando algoritmos similares, Card et al. se centró en decodificar representaciones del tracto vocal en el giro precentral. Sin embargo, utilizaron cuatro conjuntos de microelectrodos penetrantes, cada uno con 64 electrodos, insertados en el giro precentral izquierdo, el doble de la cantidad de electrodos intracorticales que en un estudio anterior[8]. Estos electrodos adicionales proporcionaron señales muy precisas y detalladas de muchas más neuronas corticales que las que se habían estudiado anteriormente.

El estudio de Card et al. confirma y valida varios hallazgos de estudios anteriores. En primer lugar, las señales motoras del habla se pueden decodificar en el contexto de la parálisis sin afasia.

En segundo lugar, los algoritmos para decodificar fonemas y aprovechar los modelos del lenguaje para construir oraciones son muy eficaces. Y en tercer lugar, el rendimiento de la decodificación mejora al aumentar la cantidad de electrodos que toman muestras de diferentes señales del habla del giro precentral.

Sin embargo, una consideración importante es que el paciente con disartria, estudiado por Card et al., tenía una función del habla intacta residual más alta que los participantes en la mayoría de los estudios anteriores (que se han centrado principalmente en pacientes paralizados con anartria).

El paciente realmente habló durante la decodificación, y es posible que su función del habla preservada contribuyera a su precisión de palabras relativamente alta y a la velocidad de entrenamiento.

Esto también puede explicar su velocidad de habla relativamente lenta, que era aproximadamente la misma que la velocidad de habla inicial del participante.

Por lo tanto, no se pueden hacer comparaciones directas con evaluaciones anteriores de neuroprótesis del habla ni generalizar el nivel de precisión y la velocidad observados por Card et al. a personas con parálisis más severa, como el síndrome de enclaustramiento.

No obstante, este estudio sugiere que las neuroprótesis del habla pueden tener beneficios en una gran población de pacientes. Las investigaciones futuras determinarán la eficacia en pacientes que se han vuelto completamente no vocales debido a la parálisis.

Un problema de larga data de los conjuntos de microelectrodos es la pérdida de células y la estabilidad a largo plazo[10]. Vansteensel et al. informan sobre la longevidad, la seguridad y el uso de una interfaz cerebro-computadora en una mujer con parálisis grave[11].

El dispositivo totalmente implantado utilizaba una conexión inalámbrica y tenía muchos menos electrodos que el dispositivo utilizado por Card et al. (la decodificación se realizó a partir de un solo par de electrodos), pero los electrodos se colocaron subduralmente, unidos a la parte inferior del hueso craneal y posicionados en la superficie del cerebro.

No penetraron la corteza. El objetivo del tratamiento, que tuvo éxito, no era decodificar el habla, sino permitir que un participante diera órdenes de clic para deletrear y llamar a su cuidador.

Durante varios años, dependió de la interfaz cerebro-computadora para comunicarse. Sin embargo, en los últimos años, el rendimiento de la interfaz cerebro-computadora disminuyó, y esto se atribuyó a la neurodegeneración progresiva de la ELA. Este estudio plantea interrogantes sobre el rendimiento a largo plazo de las interfaces cerebro-computadora en pacientes con enfermedades neurodegenerativas progresivas como la ELA.

Es posible que en el futuro sea necesario establecer una interfaz con diferentes regiones del cerebro que puedan verse menos afectadas (o menos propensas a la degeneración durante la progresión de la enfermedad), pero la actividad de dichas regiones puede ser más difícil de decodificar.

La estabilidad de los registros de electrodos durante un período de 7 años fue sólida a pesar de la progresión de la enfermedad y es coherente con los hallazgos de otros estudios que incluyeron registros en la superficie cerebral.

Un estudio mostró la decodificación del habla bilingüe 4 años después de la implantación en un paciente con anartria debido a un accidente cerebrovascular en el tronco encefálico.12.

Los estudios de Card et al. y Vansteensel et al. proporcionan nuevas pruebas convincentes de un rápido progreso en aplicaciones clínicamente viables y prácticas de las interfaces cerebro-computadora para restablecer la comunicación en personas que viven con parálisis.

Ambos grupos utilizaron interfaces neuronales de grado de investigación de generación anterior con limitaciones en términos de recuento de electrodos y bioestabilidad a largo plazo. Pero estos y otros estudios han dejado claro que las personas con parálisis pueden beneficiarse significativamente de las interfaces de comunicación cerebro-computadora, y está claro que el desarrollo de nuevos dispositivos e interfaces neuronales es sumamente necesario.

¿Qué sigue?

El dispositivo de interfaz ideal proporcionará una decodificación de alto rendimiento y fiabilidad a largo plazo (al menos una década), lo que requerirá que sea totalmente implantable (inalámbrico), con un gran ancho de banda para captar señales corticales portadoras de información que son fundamentales para la decodificación.

Además, el dispositivo debería poder implantarse (y explantarse) fácilmente sin lesionar el cerebro. Se están realizando muchos esfuerzos académicos y comerciales para abordar este desafío.

La convergencia de la neurociencia, la inteligencia artificial y la ingeniería de nuevas interfaces neuronales continúa acercándonos a la consecución del objetivo de restaurar la función de comunicación naturalista para las personas con parálisis.

Referencias Bibliográficas:

1. Card NS, Wairagkar M, Iacobacci C, et al. An accurate and rapidly calibrating speech neuroprosthesis. N Engl J Med 2024;391:609-618.

2. Vansteensel MJ, Leinders S, Branco MP, et al. Longevity of a brain–computer interface for amyotrophic lateral sclerosis. N Engl J Med 2024;391:619-626.

3. Silva AB, Littlejohn KT, Liu JR, Moses DA, Chang EF. The speech neuroprosthesis. Nat Rev Neurosci 2024;25:473-492.

Go to Citation

4. Bouchard KE, Mesgarani N, Johnson K, Chang EF. Functional organization of human sensorimotor cortex for speech articulation. Nature 2013;495:327-332.

5. Herff C, Heger D, de Pesters A, et al. Brain-to-text: decoding spoken phrases from phone representations in the brain. Front Neurosci 2015;9:217-217.

Go to Citation

6. Anumanchipalli GK, Chartier J, Chang EF. Speech synthesis from neural decoding of spoken sentences. Nature 2019;568:493-498.

Go to Citation

7. Moses DA, Metzger SL, Liu JR, et al. Neuroprosthesis for decoding speech in a paralyzed person with anarthria. N Engl J Med 2021;385:217-227.

Go to Citation

8. Willett FR, Kunz EM, Fan C, et al. A high-performance speech neuroprosthesis. Nature 2023;620:1031-1036.

9. Metzger SL, Littlejohn KT, Silva AB, et al. A high-performance neuroprosthesis for speech decoding and avatar control. Nature 2023;620:1037-1046.

Go to Citation

10. Patel PR, Welle EJ, Letner JG, et al. Utah array characterization and histological analysis of a multi-year implant in non-human primate motor and sensory cortices. J Neural Eng 2023;20:014001-014001.

Go to Citation

11. Vansteensel MJ, Pels EGM, Bleichner MG, et al. Fully implanted brain-computer interface in a locked-in patient with ALS. N Engl J Med 2016;375:2060-2066.

Go to Citation

12. Silva AB, Liu JR, Metzger SL, et al. A bilingual speech neuroprosthesis driven by cortical articulatory representations shared between languages. Nat Biomed Eng 2024 May 20