Esta tendencia ha hecho viral el fenómeno de convertir la identidad de los usuarios en objetos de colección virtual.

Por Renzo Gonzales

Fuente: Infobae

=> Recibir por Whatsapp las noticias destacadas

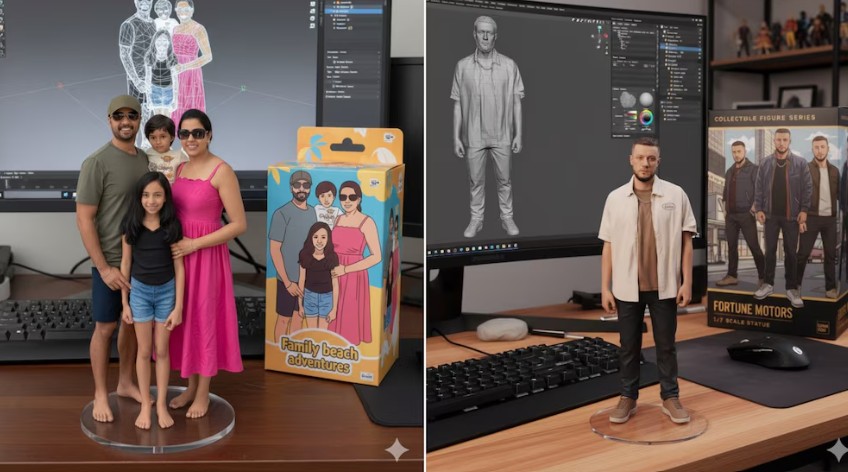

Miles de personas compartieron en redes sociales sus figuras de acción digitales creadas a partir de fotos personales mediante Nano Banana, la nueva inteligencia artificial de Google enfocada en la generación de imágenes.

Esta tendencia ha hecho viral el fenómeno de convertir la identidad de los usuarios en objetos de colección virtual, pero la experiencia reciente con tecnologías similares advierte sobre consecuencias que pueden afectar la privacidad, la seguridad de datos y la suplantación de identidad.

Filtraciones y malas prácticas en el uso de datos

Existen otros casos emblemáticos donde el uso aparentemente inofensivo de tecnologías de procesamiento de imágenes y reconocimiento facial terminó por comprometer a millones de personas. Uno de ellos fue el de Clearview AI, una compañía que funcionaba desde 2020 como un buscador de rostros, similar a los tradicionales motores de búsqueda, pero especializado en identificar personas a partir de fotografías. Clearview recopilaba datos de plataformas abiertas como redes sociales, páginas de revistas y blogs, y consolidaba una base de información biométrica masiva.

En 2022, la compañía enfrentó litigios con la Unión Americana de Libertades Civiles (ACLU) en Estados Unidos, lo que derivó en restricciones para comercializar el software de reconocimiento facial a entidades que no sean gubernamentales. Aunque mantuvo sus operaciones, la firma no logró esquivar disputas legales y sanciones económicas en diferentes países debido a la utilización y almacenamiento masivo de datos sensibles sin consentimiento claro de los afectados.

Otra muestra significativa fue el incidente registrado en Outabox, una empresa australiana dedicada a sistemas de reconocimiento facial usados en espacios de ocio nocturno. En mayo de 2024, se reportó una fuga de información confidencial, entre la que figuraban datos biométricos de reconocimiento facial, identificaciones escaneadas, firmas, membresías, domicilios, fechas de nacimiento, números telefónicos, registros de visitas y uso de máquinas tragamonedas provenientes de 19 clubes ubicados en Nueva Gales del Sur y el Territorio de la Capital Australiana.

Según individuos que declararon haber trabajado antes como desarrolladores en Outabox, la validación de la información filtrada se hizo a través de un sitio web que demostró la magnitud del acceso no autorizado a los datos. El operador ClubsNSW contrató los servicios de Outabox, y la brecha de seguridad impactó en una cantidad considerable de clientes sin su conocimiento directo ni consentimiento explícito sobre el destino de su información personal.

Entregar privacidad a cambio de entretenimiento

La inquietud no quedó solo en el pasado. En 2025, muchos usuarios recurrieron a plataformas como ChatGPT y otras IA para crear imágenes propias en el estilo de animación de Studio Ghibli. Subieron retratos personales que pasaron directamente a nutrir nuevos modelos de generación.

Esta práctica, aunque trivial en apariencia, expone el problema central en los actuales servicios basados en inteligencia artificial: estas tecnologías requieren volúmenes masivos de datos personales, sensibles y confidenciales, obtenidos mediante métodos donde casi nunca se explica con claridad el alcance real de la recopilación.

La exposición de esta información no solo facilita posibles fugas y robos perpetrados por ciberdelincuentes, sino que además aumenta la probabilidad de suplantación de identidad y fraude digital, porque el material fue proporcionado voluntariamente por los propios usuarios. La ausencia de controles robustos en el almacenamiento y procesamiento seguro de estos datos, como quedó en evidencia en el episodio de Outabox, extiende las oportunidades para ataques y vulneraciones.

Además, la recolección masiva de datos suele realizarse sin consentimiento informado de los usuarios. En muchos casos, quienes eligen estos servicios ignoran el destino final de sus fotos y datos personales y desconocen si quedarán reutilizados, almacenados indefinidamente o transferidos a terceros. Desde el punto de vista legal, ese escenario supone un grave defecto en el consentimiento y hace opacos los fines para los que esos datos resultan empleados.

Finalmente, la falta de transparencia y explicabilidad en los algoritmos y políticas de privacidad genera fricciones con las normativas locales e internacionales. Algunas empresas informan mediante cláusulas explícitas que las imágenes se emplearán para mejorar sus modelos de IA, pero la complejidad y la longitud de los documentos de privacidad coloca a los usuarios en una situación en la que difícilmente pueden comprender el alcance real de la cesión de derechos sobre sus propios datos.