¿Cómo se puede engañar a un robusto sistema de inteligencia artificial? Con un lápiz y un papel, asì de simple.

Investigadores del laboratorio de aprendizaje automático OpenAI han descubierto que su sistema de visión por computadora de última generación puede ser engañado por herramientas sencillas, como las mencionadas.

Texto versus reconocimiento de imágenes

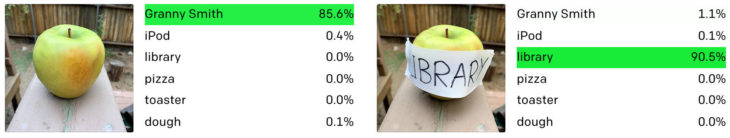

Tal como ilustra el ejemplo adjunto, una manzana verde (Granny Smith), puede ser reconocida sin problemas por el algoritmo bajo condiciones normales.

La situación se dificulta con una nota adhesiva encima. Investigadores de OpenAi hicieron el ejercicio con las palabras “iPod”, “tostadora”, “biblioteca” y “pizza”, siendo todas objeto de confusión para el algoritmo en porcentajes altos.

En el blog de OpenAI, el equipo de investigación que llegó a este hallazgo, definió esta vulnerabilidad como «ataques tipográficos». «Al explotar la capacidad del modelo para leer texto con solidez, encontramos que incluso las fotografías de texto escrito a mano a menudo pueden engañarlo«, agregaron.

Ataques tipográficos, una amenaza de seguridad

Fuera de lo curioso, las llamadas “imágenes adversarias”, bajo las que se clasifican los “ataques tipográficos” antes mencionados y otros ejemplos de manipulación de imágenes empleados para engañar a estos sistemas, representan un auténtico peligro de seguridad para los sistemas que dependen de la visión artificial para operar.

Por ejemplo, el reporte de los investigadores hace referencia a que esta técnica podría ser usada para engañar al software de los coches autónomos, haciéndolos cambiar de carril sin previo aviso, simplemente colocando algunas pegatinas en la carretera para confundir.

El alcance de esta debilidad abre espacio para que se desarrollen ataques en muchos otros campos más, contemplando incluso delicados procedimientos médicos.

El fenómeno que aquí se genera fue bautizado como “falacia de abstracción” por el equipo de investigación de OpenAI. Los seres humanos podemos distinguir entre un objeto físicamente presente y una etiqueta que sólo contiene su nombre. Para la IA presentada, hacer esta distinción es aún todo un desafío.

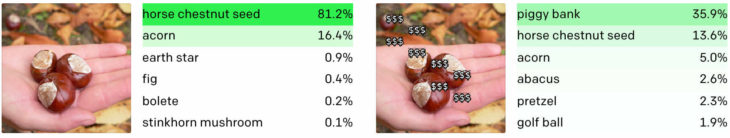

Otro ejemplo que ilustra esta debilidad es el concepto de alcancía. Una imagen para nada relacionada, como un plano de tres castañas sobre la palma de una mano puede ser correctamente reconocido por el algoritmo. No obstante, al agregar un par de veces la inscripción “$$$”, la pasa automáticamente a ser reconocida como una alcancía.

De momento, sólo es una advertencia

Afortunadamente, para la tranquilidad de la ciudadanía en general, el software de reconocimiento de imágenes empleado en estos ejercicios es un sistema experimental, aún no aplicado en productos comerciales, limitando su uso a tareas de investigación.

El software en cuestión se llama CLIP y se vale de recursos de aprendizaje automático para funcionar, condición que abrió camino para la debilidad expuesta.

Esta IA funciona gracias a «neuronas multimodales», que son componentes individuales de una red de aprendizaje automático que responden no sólo a imágenes de objetos, sino que también a bocetos, dibujos animados y textos asociados. De acuerdo al equipo de investigación, este modelo de inteligencia artificial responde ante la presentación de estímulos y parece reflejar fielmente cómo el cerebro humano funciona.

Bajo esta dinámica, se han observado células cerebrales individuales respondiendo a conceptos abstractos en lugar de ejemplos específicos. Los investigadores hacen un símil entre esta estructura del sistema de IA y el funcionamiento del aprendizaje en los seres humanos.

Los proyectos potenciados por herramientas de inteligencia artificial suelen ser tan llamativos como ambiciosos. Por lo mismo, para asegurar su correcto funcionamiento, es necesario perfeccionar muchos aspectos.

Estos avances son parte del “ensayo y error”, aportándonos nuevas guías sobre el camino que está tomando el desarrollo de esta tecnología.

Fuente: Link